Apache Spark предоставляет мощные инструменты для обработки больших объемов данных. При разработке приложений на Apache Spark логирование играет важную роль для отслеживания процесса выполнения задач...

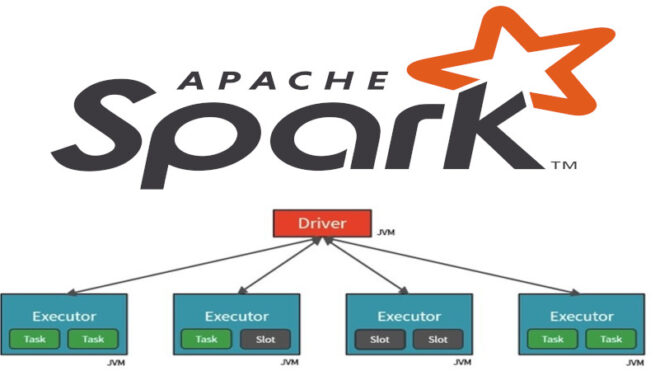

Что такое Spark-драйвер и как его настроить

Apache Spark является мощным фреймворком для обработки больших объемов данных параллельно на кластерах. Он предоставляет высокоуровневые API на Java, Scala, Python и R, что делает...

Вопросы на знание основ работы распределенного фреймворка Spark: открытый комплексный тест для начинающих

Чтобы самостоятельное обучение по Spark стало еще интереснее, сегодня мы предлагаем вам контрольный общий тест по основам работы распределенного фреймворка Apache Spark, включая его особенности,...

Что такое Spark GraphX

Apache Spark предоставляет мощный набор инструментов для обработки больших объемов данных, и Spark GraphX - это его компонент, специализирующийся на анализе графов. Графовые структуры широко...

Что такое пары ключ/значение в Spark

Apache Spark - это мощный инструмент для обработки больших объемов данных и анализа данных в реальном времени. Одним из ключевых элементов Spark является работа с...

Что такое пользовательские функции в Spark

Apache Spark - это мощный инструмент для обработки данных и анализа больших объемов информации. Однако иногда вам может понадобиться провести сложные операции на данных, которые...

10 вопросов на знание основ фреймворка Spark: открытый интерактивный тест для начинающих изучать Spark

Чтобы самостоятельное обучение по Spark стало еще интереснее, сегодня мы предлагаем вам общий тест по основам работы распределенного фреймворка Apache Spark, включая его особенности, структуры,...

Что такое диспетчеры кластеров в Spark

Apache Spark - это мощный инструмент для обработки больших объемов данных в распределенных кластерах. Для эффективного использования Spark необходимо правильно управлять ресурсами кластера. Для этого...

Что такое распараллеливание в Spark

Apache Spark - это мощный фреймворк для обработки больших объемов данных в распределенной среде. Он предоставляет разнообразные инструменты и библиотеки для обработки и анализа данных,...

Что такое параллелизм в Spark

Apache Spark - это мощный фреймворк для обработки больших объемов данных, который предоставляет распределенные вычисления на кластерах. Один из ключевых факторов, влияющих на производительность Spark...