Чтобы самостоятельное обучение по Spark стало еще интереснее, сегодня мы предлагаем вам общий тест по основам работы распределенности в Apache Spark, включая ее особенности, структуру,...

10 вопросов на знание основ работы фреймворка Spark: открытый общий комплексный тест для начинающих

Чтобы самостоятельное обучение по Spark стало еще интереснее, сегодня мы предлагаем вам общий тест по основам работы распределенного фреймворка Apache Spark, включая его особенности, структуры,...

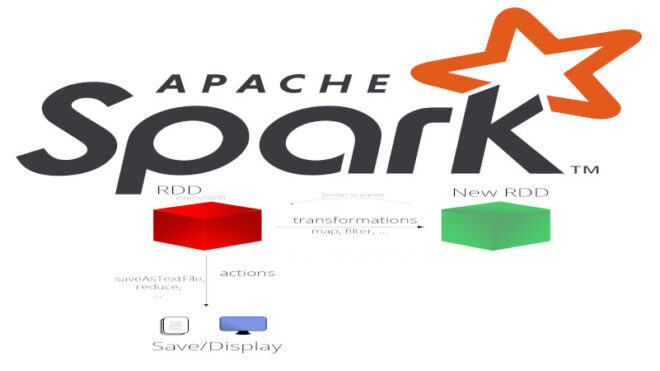

Что такое RDD и для чего это нужно фреймворку Spark

Набор RDD (Resilient Distributed Dataset) – это неизменяемая коллекция объектов данных. Каждый такой набор делится на определенное количество частей, которые обрабатываются различными узлами в кластере....

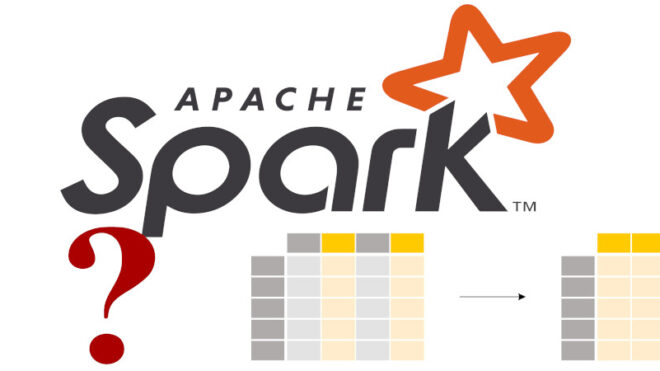

10 вопросов на знание основ работы со структурами данных в Spark: открытый интерактивный тест для начинающих

Чтобы самостоятельное обучение по Spark стало еще интереснее, сегодня мы предлагаем вам простой тест по основам работы со структурами данных в распределенном фреймворке Apache Spark,...

10 вопросов на знание основ работы фреймворка Spark: открытый комплексный тест для начинающих

Чтобы самостоятельное обучение по Spark стало еще интереснее, сегодня мы предлагаем вам комплексный тест по основам работы распределенного фреймворка Apache Spark, включая его особенности, структуры,...

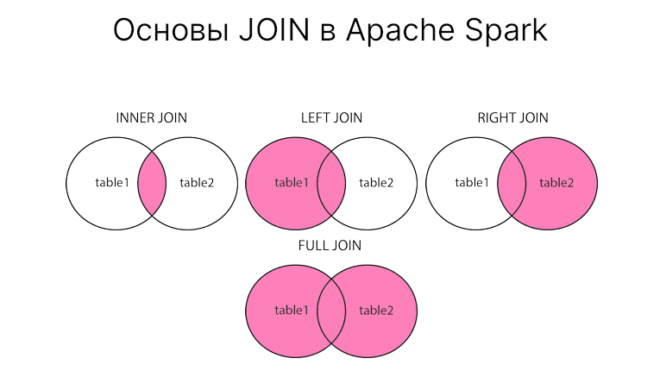

Соединяй и властвуй: основы JOIN

Иногда приходится работать с несколькими связанными таблицами сразу, причем требуется их каким-то образом соединять. В этом случае вам поможет операция JOIN в PySpark. Сегодня расскажем...

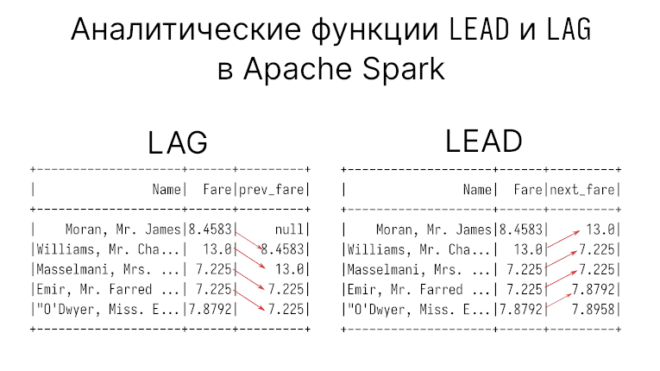

Оконные функции: LAG и LEAD

В предыдущей статье мы говорили о ранжирующих функциях из семейство оконных (window function) в PySpark. В этой статье пойдет речь об аналитических функциях LEAD и...

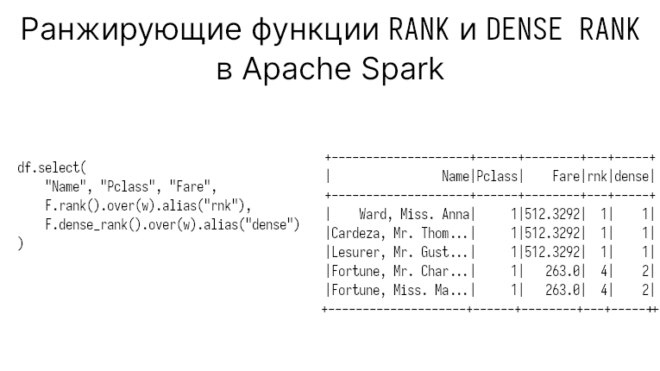

Зачем вам вычислять ранг RANK и DENSE RANK

В прошлой статье мы говорили о ранжирующей функции ROWS NUMBER в PySpark. Сегодня поговорим о RANK DENSE_RANK, а также узнаем, чем они различаются. Данные с...

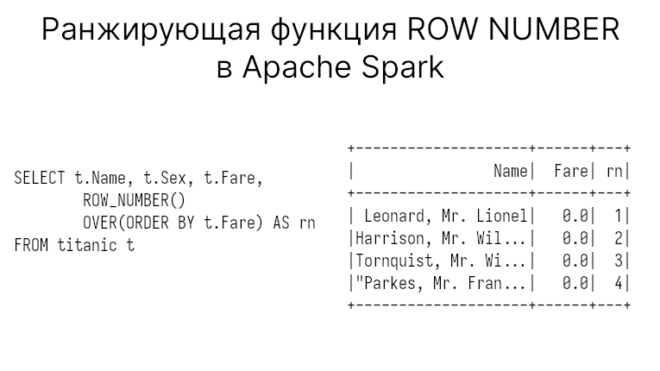

Зачем вам считать строки ROW NUMBER

В прошлый раз мы говорили о использовании агрегирующих функциях с использованием окон (window function) в PySpark. Сегодня поговорим об одной из ранжирующих функций ROW NUMBER,...

Как посчитать скользящую среднюю

Скользящая средняя (moving average) часто применяется для анализа и определения трендов в данных. Она рассчитывается как среднее текущего и заданного числа предыдущих значений за некоторый...