Сегодня расскажем, как работать с файлами формата JSON в PySpark. В этой статье вы узнаете: как прочитать файл JSON, каким должен быть формат, чтобы PySpark...

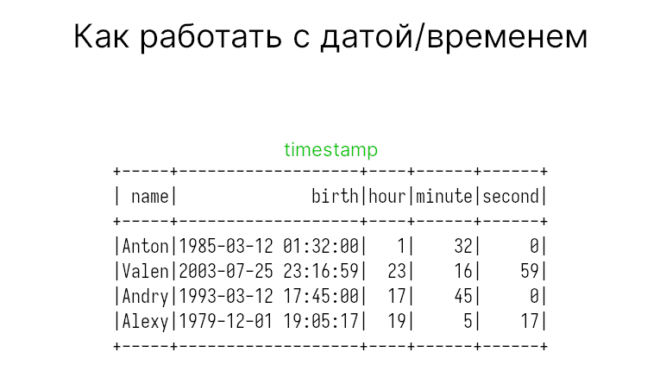

Работаем со временем (timestamp) в Apache Spark

В прошлой статье мы говорили о датах в Apache Spark. Сегодня затронем представление дата/время или timestamp. В этой статье вы узнаете как представить и преобразовать...

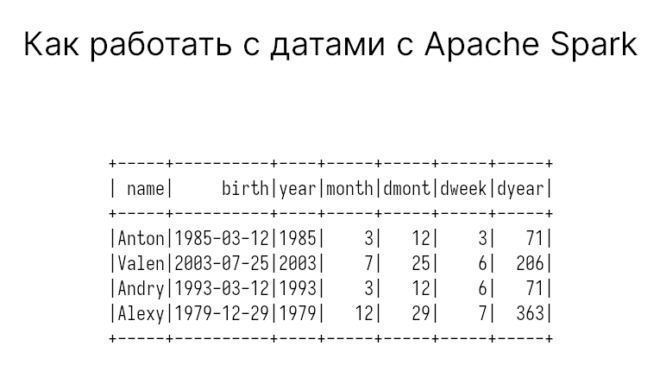

Работаем с датами в Apache Spark

Сегодня расскажем о способах работы с датами в Apache Spark. В этой статье вы узнаете: как создать DataFrame с датами; как преобразовать столбец в корректное...

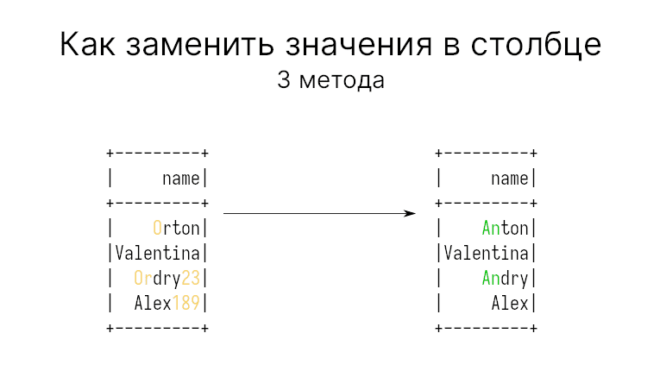

Как заменить значения в столбце

При работе со строками иногда приходится заменять одни строки столбца DataFrame на другие. Apache PySpark предлагает массу возможностей это сделать. В этой статье поговорим о...

Объединение таблиц с union и unionByName

Может случиться так, что вам нужно объединить два DataFrame в PySpark. Как это можно сделать? В этой статье мы расскажем, как объединить две или более...

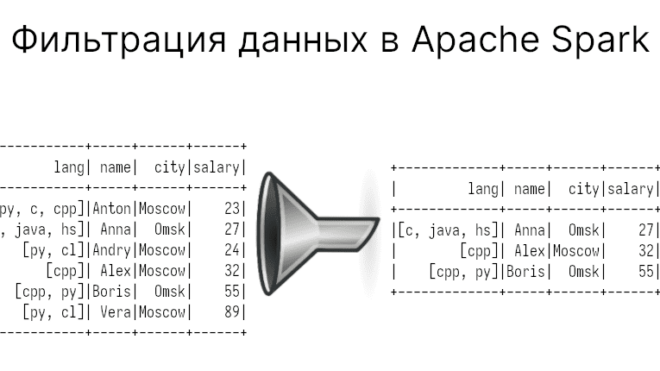

Фильтрация данных в Apache Spark: лучшие практики

В прошлой статье мы говорили о вычислении SQL-выражений в Apache Spark, а также немного затронули тему фильтрации данных. В этот раз углубимся в эту тему,...

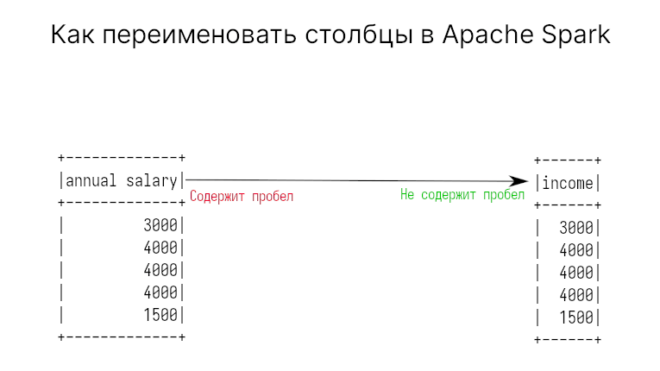

Как переименовать столбцы в Apache Spark

Встречались ли с ситуациями, когда имя столбца в PySpark неправильно написано или содержит пробелы, а вы хотели бы его переименовать? Тогда эта статья для вас....

5 способов вычисления SQL-выражений в Spark

Если вы знаете SQL, но еще не освоились с фреймворком Apache Spark, то вы можете выполнять запросы различными способами. В этой статье вы узнаете, как...

Из строк в столбцы с помощью функции pivot

В этой статье мы поговорим о способе преобразования столбцов в строки в Apache Spark. Для этого воспользуемся специальным методом (функцией) — pivot. Группировка не преобразует...

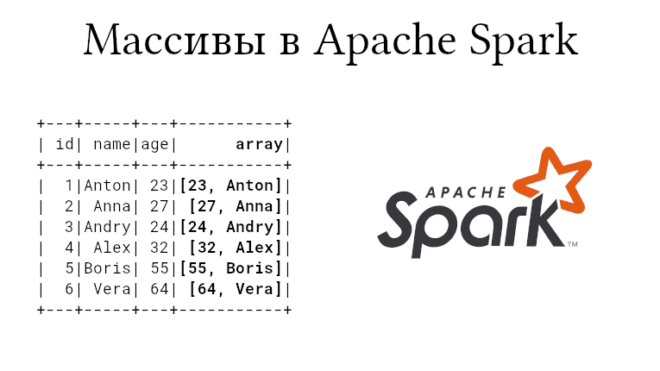

Управление массивами в Apache Spark

Массивы являются базовыми структурами данных, поэтому ожидаемо, что в Apache Spark есть поддержка базовых операция для работы с ними. В этой статье мы рассмотрим функции...