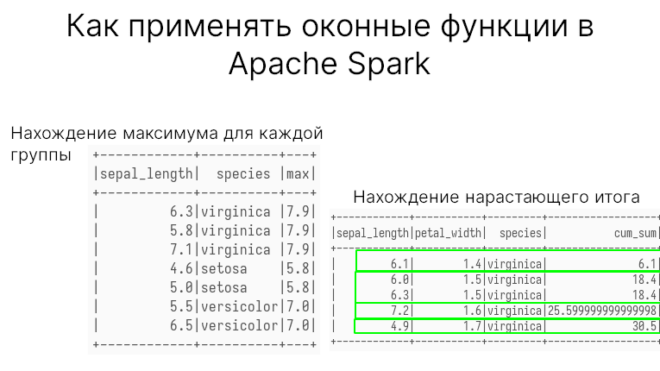

Apache Spark SQL поддерживает оконные функции (window functions), которые могут пригодиться для различных задач, например для получения нарастающего значения или скользящей средней. В этой статье...

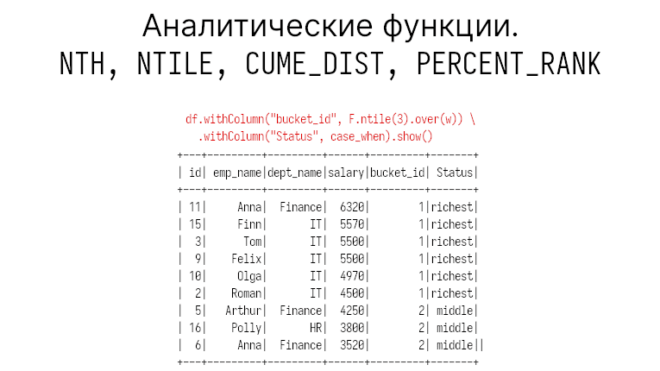

Оконные функции: NTH, NTILE, CUME_DIST, PERCENT_RANK

В предыдущей статье мы говорили о фреймах оконных функций (window functions) в PySpark. Сегодня мы затронем такие аналитические функции, как NTH, NTILE, CUME_DIST, PERCENT_RANK. Исходные...

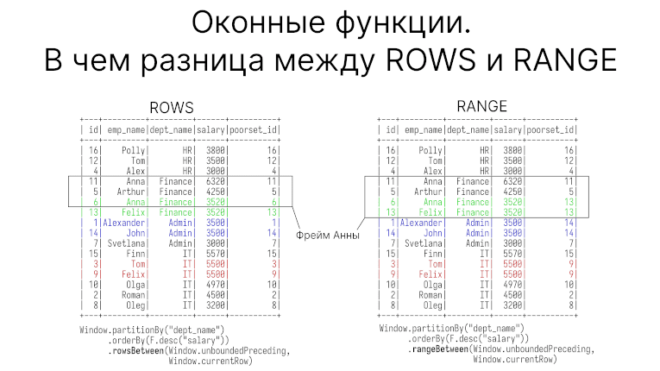

Как задаются границы фрейма в оконных функциях

Оконные функции (window functions) — один из полезных инструментов для обработки и анализа данных в PySpark. В этой статье на примере простых функций first_value и...

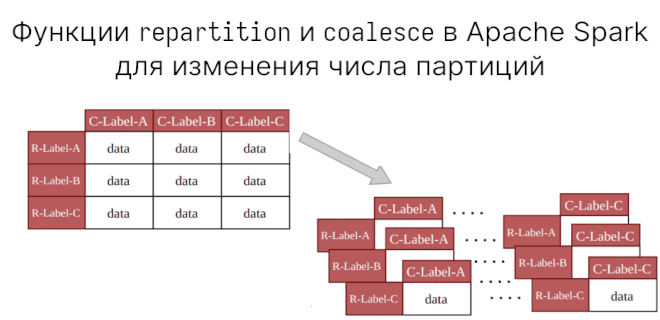

Зачем вам функции repartition и coalesce

Мы уже говорили о создании партиций (partitions) на диске с помощью partitionBy. В Apache Spark есть еще функции для работы с партициями. Сегодня рассмотрим разницу...

4 совета по оптимизации Apache Spark

В прошлый раз мы рассмотрели 6 способов повышения производительности Apache Spark: кэширование, трансляция, бакетирование, минимизация перетасовки (shuffle), применение оконных функций и контрольных точек. Дадим еще...

6 способов повышения производительности в Apache Spark

Apache Spark применяется для работы с большими данными (Big Data), поэтому встает вопрос: как увеличить скорости обработки этих данных. В этой статье мы рассмотрим 5...

Зачем вам бакетирование в Apache Spark

В предыдущей статье мы поговорили о разнице между партициями и бакетами Apache Spark. Сегодня на реальном примере покажем, как бакетирование помогает писать оптимизированные запросы без...

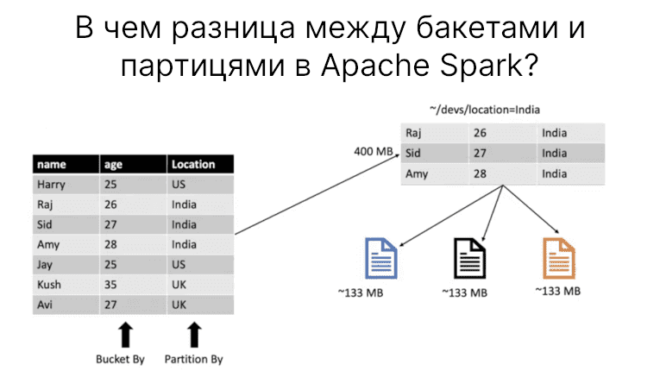

В чем разница между партициями и бакетами

При оптимизации работы Apache Spark рекомендуют делать партиции и бакеты. Однако в чем разница между партицированием и бакетированием? В этой статье мы разберемся в этом....

Как разбить датасет на партиции с помощью partitionby

Чтение больших данных (Big Data) занимает время. Одним из способов работы с большими объемам является разбиение большого датасет на части, или партиции. Сегодня мы поговорим...

Функции PySpark SQL для работы с JSON

В предыдущий раз мы говорили о чтение и записи JSON файлов в PySpark. Сегодня затронем функции для работы с JSON. Читайте в этой статье: как...